Apple revisará todos tus fotos de iCloud en búsqueda de abuso infantil

Sí, has leído bien. Apple revisará las fotos de todos los usuarios de sus productos para ver si tienen alguna fotografía relacionada con pornografía o abuso infantil, y si encuentran alguna, llamarán directamente a la policía.

A simple vista, suena como una buena forma de prevenir el abuso infantil, pero detrás hay mucho más de lo que se ve, y deberías saberlo.

Evitar la difusión de material de abuso sexual infantil

A finales de este año , Apple lanzará una tecnología llamada NeuralHash, que les permitirá detectar e informar a las fuerzas del orden sobre material conocido de abuso sexual infantil de una manera que preservará la privacidad del usuario.

Dicho de otra manera, Apple comparará todas tus fotos contra las fotos conocidas de abuso infantil. Si encuentran una coincidencia en tu galería de fotos, estarás en un buen lío.

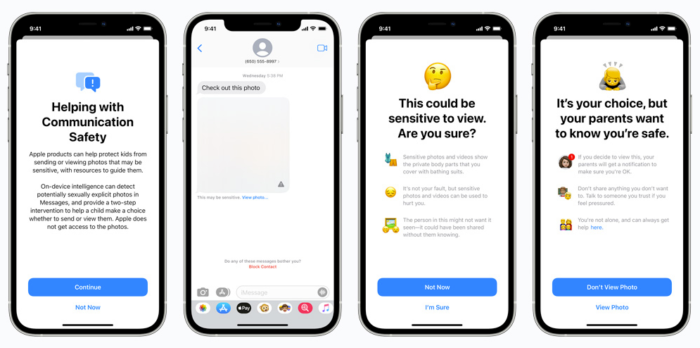

Según Apple, la detección de material de abuso sexual infantil (CSAM) es una de varias funcionalidades nuevas destinadas a proteger mejor a los niños que usan sus servicios contra daños online, incluidos filtros para bloquear fotos potencialmente sexualmente explícitas enviadas y recibidas a través de la cuenta de iMessage de un niño.

Otra funcionalidad intervendrá cuando un usuario intente buscar términos relacionados con MASI (Material de Abuso Sexual Infantil) a través de Siri o del buscador del móvil.

La mayoría de los servicios en la nube (Dropbox, Google Drive y Microsoft OneDrive) ya analizan los archivos de los usuarios en busca de contenido que pueda violar sus términos de servicio o ser potencialmente ilegal, como MASI.

Pero Apple se había resistido durante mucho tiempo a escanear los archivos en la nube de los usuarios al brindarles la opción de cifrar sus datos antes de que lleguen a los servidores iCloud de Apple.

Apple dice que su nueva tecnología de detección MASI, NeuralHash, funciona en el dispositivo del usuario y puede identificar si un usuario carga imágenes conocidas de abuso infantil en iCloud, sin necesidad de descifrar las imágenes hasta que se alcanza un umbral y una secuencia de comprobaciones para verificar que el contenido se borra.

La intención parece buena, pero no olvidemos que el camino del infierno está empedrado con buenas intenciones.

¡Sigue leyendo!

Cómo funciona exactamente NeuralHash

En realidad, NeuralHash no es nada nuevo, la mayoría de ONGs que luchan contra el abuso infantil a nivel mundial, utilizan tecnología similar, aunque de una manera menos eficiente y más invasiva.

Imagina que todas las imágenes tienen una especie de huella digital única, a lo que llamaremos hash. Si quieres saber qué es exactamente un hash, pincha encima del enlace. Mientras tanto, piensa en el hash como una huella digital.

Entonces, cuando las autoridades apresan un criminal, lo primero que hacen es hacerle una foto y tomar sus huellas digitales, de este modo, quedan identificados para siempre. Y si algún día esas huellas aparecen en un lugar en el que no deberían, es fácil saber a quién pertenecen.

Pues la tecnología de Apple básicamente lo que hace es crear una base de datos con las huellas digitales (hashes) de todas las fotografías de abuso infantil conocidas.

Y a continuación, compara cada una de tus fotos con cada una de las fotos de la base de datos de material de abuso infantil, proporcionada por organizaciones de protección infantil de todo el mundo, como el Centro Nacional para Niños Desaparecidos y Explotados (NCMEC).

De hecho, lo que se compara es el hash de tus fotos contra el hash de las fotos en la base de datos MASI. Y esa es la razón por la que Apple dice que no viola la privacidad de sus usuarios.

En el momento en el que el algoritmo detecta en tu colección de fotos un hash que coincide con la base de datos de material de abuso infantil, entonces saltan todas las alarmas.

Las debilidades de la tecnología NeuralHash de Apple

NeuralHash es efectivo para evitar la difusión de contenido conocido relacionado con abuso infantil, pero es posible que tengas un millón de fotografías haciendo lo peor que te puedas imaginar, y si esas fotos no están en la lista MASI (CSAM) entonces NeuralHash no hará absolutamente nada.

De hecho es peor, si tomas fotos conocidas de pornografía infantil y las modificas en lo más mínimo (la rotas, le aplicas un filtro o le añades texto, etc.), el hash será nuevo, y por tanto no estará en la base de datos de MASI.

Si eres un poco perspicaz coincidirás conmigo en que este tipo de tecnologías simplemente servirá para hacer que los enfermos, maniáticos y depravados sexuales de todo el mundo sean más cuidadosos y creativos a la hora de compartir este tipo de contenido malsano.

Lo ideal sería que Apple revisé el contenido de cada fotografía en lugar de limitarse al hash, pero esto si sería una violación a la privacidad de las personas.

De hecho, firmaría ahora mismo para que Apple o quien sea lance una tecnología que revise el contenido de todas las fotos en búsqueda de material CSAM, pero solo si se aplica a todo el mundo por igual, empezando por las elites (gobernantes, ricos y millonarios) de todo el mundo, que a menudo es donde más abundan los degenerados.

Pero eso nunca sucederá, porque el verdugo nunca afila el hacha para su propio cuello.

Luego está el factor accidental. Seguro que alguna vez has estado navegando por internet, y sin querer haz terminado pinchando en un enlace que ha descargado un archivo no deseado.

Si alguna vez te descargaste una canción de Kazaa o una película a través de eMule, sabes de que te hablo. Si te pasa eso, tendrás que dar muchas explicaciones.

El gran peligro de la tecnología NeuralHash de Apple

En un mundo polarizado y lleno de etiquetas como en el que vivimos, no hay más que dar un vistazo por las redes sociales para encontrarnos con un uso libertino de términos como conservador, liberal, progresista, rojo, facha, extremista, negacionista, y un larguísimo etcétera.

Los individuos identificados en esas categorías, a menudo comparten memes, videos que promueven sus ideales o se burlan de ideologías contrarias.

¿Qué pasa si las tecnológicas o los gobiernos utilizan el NeuralHash para identificar el tipo de contenido que descargas o compartes y a partir de ahí encasillarte en una categoría específica?

Por ejemplo, supongamos que te has descargado varios memes burlándose de Donald Trump o videos criticando al presidente de tu país, una tecnología como NeuralHash servirá para crear un perfil bastante preciso de tus gustos o afiliaciones.

Y ese conocimiento en las manos equivocadas se convierte más en una amenaza que en un beneficio.

Disponibilidad de NeuralHash

NeuralHash aterrizará en iOS 15 y macOS Monterey, y está programado para ser lanzado este otoño, probablemente con el lanzamiento del nuevo iPhone.

Apple anunció que NeuralHash se lanzará inicialmente en Estados Unidos, pero no han dicho nada sobre sus planes de despliegue a nivel internacional.

Hasta hace poco, empresas como Facebook se vieron obligadas a apagar sus herramientas de detección de abuso infantil en toda la Unión Europea después de que la práctica fuera prohibida inadvertidamente.

Apple dijo que la función es técnicamente opcional en el sentido de que no tienes que usar Fotos de iCloud, pero será un requisito si los usuarios lo hacen. Después de todo, el dispositivo pertenece al usuario, pero la nube de Apple no.

Apple ha publicado detalles técnicos en su sitio web sobre cómo funciona NeuralHash, que fue revisado por expertos en criptografía y elogiado por organizaciones de protección infantil.

Pero a pesar del amplio apoyo de los esfuerzos para combatir el abuso sexual infantil, todavía hay un componente de vigilancia con el que muchos se sentirían incómodos, y esa es la razón por la que varios expertos en seguridad están pidiendo más discusión pública antes de que Apple lance la tecnología a los usuarios.

Déjanos tu comentario y dime qué opinas de esta tecnología de detección de imágenes de abuso infantil conocida como NeuralHash.